Panduan pemula cara setting robots.txt diblogger

Selamat Datang di Blog Orang IT. Bagi kalangan blogger setting robots.txt untuk keperluan SEO itu antara penting dan tidak penting. Ini karena pengguna melihat peringatan didashboard blogger terkait pengaturan robots.txt bahwa pengaturan yang tidak tepat dari fitur tersebut dapat mengakibatkan blog anda diabaikan oleh mesin telusur. Peringatan itulah yang membuat blogger pemula takut mengotak-atik pengaturan robots.txt dan membiarkannya dalam keadaan default

Oleh sebab itu pada postingan kali ini saya akan menjelaskan secara dasar pengertian robots.txt dan bagaimana mengatur robots.txt yang aman untuk SEO

Pertama kita pahami terlebih dahulu tentang pengertian robots txt.

Robots.txt (Robot exclusion protocol) merupakan sebuah aturan yang mencegah dan membolehkan mesin perayap untuk menjelajahi seluruh halaman yang ada didalam website. Melalui robots.txt kita bisa mencegah agar googlebot tidak merayapi halaman seperti pencarian , arsip , label untuk menghemat crawl budget

Ketika robot mesin perayap datang kesitus anda maka yang pertama kali mereka lihat adalah aturan perayap yang ada didalam file robots.txt mengenai format halaman yang boleh di indeks dan tidak perlu di indeks.

Mesin perayap akan menggunakan isi dari file robots.txt sebagai pedoman penelusuran oleh sebab itu dapat dikatakan kalau pengguna salah mengatur robots.txt maka mesin pencari tidak akan merayapi halaman yang dikecualikan dan itu berarti tidak ada prioritas peringkat untuk halaman itu (diabaikan meski di indeks)

Setelah membaca robots.txt maka mesin perayap akan mulai melakukan perayapan pada seluruh halaman anda dengan tag allow atau mengecualikan halaman dengan format /search yang memang disetting disallow

Cara mengatur robots.txt

Membiarkan robots.txt dalam keadaan nonaktif didashboard blogger bukan berarti blog anda tidak memberikan panduan kepada mesin perayap , secara default platform blogger memiliki aturannya sendiri yang bisa anda lihat dengan menambahkan url /robots.txt dibelakang nama domain

Contoh : https://www.helmynia.com/robots.txt

Ini adalah aturan robots.txt bawaan blogger (default) yang belum mengalami perubahan apapun

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /search

Allow: /

Sitemap: https://www.helmynia.com/sitemap.xml

Kalau dijelaskan setiap baris artinya seperti ini :

User-agent: Mediapartners-Google [ nama alias untuk mesin perayap yang bekerja sama dengan google yakni adsense ]

Disallow: [ tidak di ijinkan , karena kosong berarti tidak ada halaman yang diblokir artinya mesin perayap adsense boleh merayapi semua halaman ]

User-agent: * [ semua robot mesin perayap disimbolkan sebagai * , robot perayap ada banyak jenisnya mulai dari search engine , robot perayap dari ahrefs untuk mengetahui backlink anda dll ]

Disallow: /search [ tidak di ijinkan untuk merayapi halaman setelah /search , tau halaman apa saja yang menggunakan format url ini ? halaman label (https://www.helmynia.com/search/label/Blog) , halaman pencarian (https://www.helmynia.com/search?q=foto+helmy) , halaman arsip dll ]

Allow: / [ selain yang ditetapkan diatas di ijinkan untuk dirayapi ]

https://www.helmynia.com/sitemap.xml [ ini adalah peta situs yang isinya seluruh url postingan , tidak mencakup url halaman statis ]

Jadi , mesin perayap dari google adsense boleh merayapi seluruh halaman blog. Semua mesin perayap selain yang ditetapkan diatas tidak boleh merayapi halaman setelah /search dan boleh merayapi halaman setelah / berdasarkan daftar url yang terdapat pada sitemap

Untuk tidak mengindeks-kan halaman tertentu caranya bukan menggunakan robots.txt namun menggunakan tag noindex. Oleh sebab itu halaman yang anda tentukan didalam robots.txt mungkin dicekal (tidak bisa dirayapi oleh robot) namun tetap di indeks dan tidak mendapat prioritas.

Oleh sebab itu pengguna blogger biasanya melihat laporan cakupan indeks dilaman search console dengan status peringatan ; di indeks meski diblokir oleh robots.txt

Artinya google berusaha memberi tau anda bahwa halaman tersebut di indeks tapi tidak memperbolehkan robot lain untuk merayap apakah anda sudah tau ? jika belum gunakan tag noindex untuk mencegah google merayapi halaman tersebut ( jadi ini hanya peringatan / sekedar informasi )

Contoh robots.txt hasil custom

User-agent: Mediapartners-Google

Disallow:

User-agent: *

Disallow: /p/about.html

Disallow: /p/contact.html

Allow: /

Sitemap: https://helmynia.com/sitemap.xml

Sitemap: https://helmynia.com/sitemap-pages.xml

Anda mencegah halaman about dan contact untuk dirayapi oleh robot jadi kalau ada tautan link yang mengarah kehalaman itu otomatis akan diblokir dan halaman tersebut tidak akan mendapatkan prioritas dihalaman mesin pencari karena memang dianggap tidak penting tetapi tetap terindeks

Anda bisa menambahkan halaman lain seperti privacy policy , disclaimer atau halaman yang anda ingin diabaikan oleh mesin perayap karena dianggap tidak penting

Sementara format:

Sitemap: https://helmynia.com/sitemap-pages.xml

Berisi daftar postingan yang anda buat dihalaman statis bukan dihalaman entry. Tapi memang halaman yang dibuat pada halaman statis sifatnya sebagai pelengkap jadi tidak begitu penting hingga harus ditambahkan kedalam hasil pencarian

Cara mengatur robots.txt

Jika anda mengalami suatu masalah, misal iklan adsense jarang tampil dan menurut halaman "bantuan adsense" mereka menyarankan agar publisher menghapus 2 baris kode :

User-agent: Mediapartners-Google

Disallow:

Silahkan dihapus itu tidak mengapa karena sudah ada kode alias * yang artinya semua mesin perayap termasuk adsense

Pertama silahkan buka dashboard blogger > pergi ke menu setelan > preferensi dan penelusuran > lihat dijendela sebelah kanan cari robots.txt khusus kemudian pastekan robots.txt yang sudah anda custom dan simpan perubahan

Setelah itu cek domain anda https://www.helmynia.com/robots.txt apakah isi robots.txt nya sudah berubah atau belum

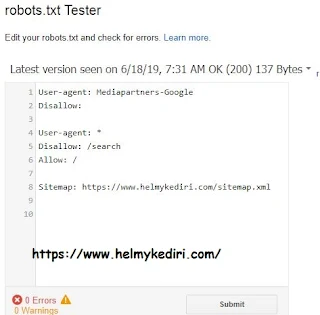

Selanjutnya kita kirimkan robots.txt yang baru kita rubah ke google supaya lebih cepat diterapkan atau kalau blog anda selalu up to date maka tinggal menunggu saja

Buka halaman google search console

https://www.google.com/webmasters/tools/robots-testing-tool?hl=en&siteUrl=https://www.helmynia.com/

Pada menu crawl > robots.txt tester silahkan paste isi file robots.txt yang baru kemudian tekan submit

Jika anda menerima peringatan halaman di indeks tapi diblokir robots.txt silahkan hilangkan tanda /search menjadi seperti ini

User-agent: *

Disallow:

Sitemap: https://helmynia.com/sitemap.xml

Sitemap: https://helmynia.com/atom.xml?redirect=false&start-index=1&max-results=500

Sitemap: https://helmynia.com/atom.xml?redirect=false&start-index=501&max-results=500

Sitemap: https://helmynia.com/feeds/posts/default

Sitemap: https://helmynia.com/sitemap-pages.xml

Itu akan menghilangkan peringatan di indeks tapi diblokir robots.txt tapi sebenarnya itu bukan masalah error karena sekali lagi anda harus menghemat crawl budget anda untuk halaman-halaman yang diprioritaskan peringkatnya. Crawl budget itu seperti nilai PR/PA yang dibagi pada setiap halaman blog anda dan terkadang halaman tidak penting juga mendapatkan nilai seperti halaman statis padahal halaman entry jauh lebih penting untuk di indeks

Bagaimana dengan format sitemap

Sitemap: https://helmynia.com/atom.xml?redirect=false&start-index=1&max-results=500

Itu hanya berisi daftar url blog dari url 1 sampai 500

Sementara format sitemap ini

Sitemap: https://helmynia.com/feeds/posts/default

Berisi 50 url yang di urutkan berdasarkan update terakhir

Tetapi menggunakan 1 sitemap ini

Sitemap: https://helmynia.com/sitemap.xml

Sudah menghandle seluruh url blog anda meski isi kontennya puluhan ribu jadi tidak ada alasan untuk membackup sitemap lain yang error karena sitemap sendiri sifatnya digenerate secara otomatis satu-satunya alasan anda melihat pesan error adalah karena mesin perayap kehabisan crawl budget sehingga proses perayapan berhenti ditengah jalan

Meski demikian itu akan fix dengan sendirinya tidak ada yang perlu dicemaskan

Demikian postingan mengenai panduan pemula untuk mengatur sitemap , sekarang anda sudah paham mengenai penjelasan setiap baris dari robots.txt yang digunakan dalam situs anda.

Anda bisa mengotak-atik isi sitemap dan tidak takut lagi dengan notifikasi peringatan blogger karena anda sudah paham

Sekian dan terimakasih

Posting Komentar untuk "Panduan pemula cara setting robots.txt diblogger"

Posting Komentar

Artikel di blog ini bersumber dari pengalaman pribadi penulis, tulisan orang lain sebagai posting tamu maupun bayaran oleh sebab itu segala hak cipta baik kutipan dan gambar milik setiap orang yang merasa memilikinya